Le immagini pubblicate su Instagram, Facebook e Threads create con sistemi di intelligenza artificiale generativa saranno identificate ed etichettate. Lo ha specificato Meta in una nota pubblicata oggi, 6 febbraio 2024, in cui spiega inoltre di essere al lavoro insieme ad altre aziende per sviluppare standard tecnici comuni utili a riconoscere i contenuti AI, anche di tipo audio e video.

Meta etichetterà le immagini di Facebook, Instagram e Threads create con l’AI

Si tratta di una mossa che mira a fare ordine in un momento in cui comincia a essere difficile distinguere i contenuti reali da quelli falsi creati dai software di intelligenza artificiale, già causa di problemi sia sui social network che altrove. Una politica che punta sulla trasparenza è doverosa, sottolinea Meta, che vuole anche per questo collaborare con altre realtà del settore per istituire soluzioni comuni con cui semplificare la segnalazione di contenuti generati dall’AI.

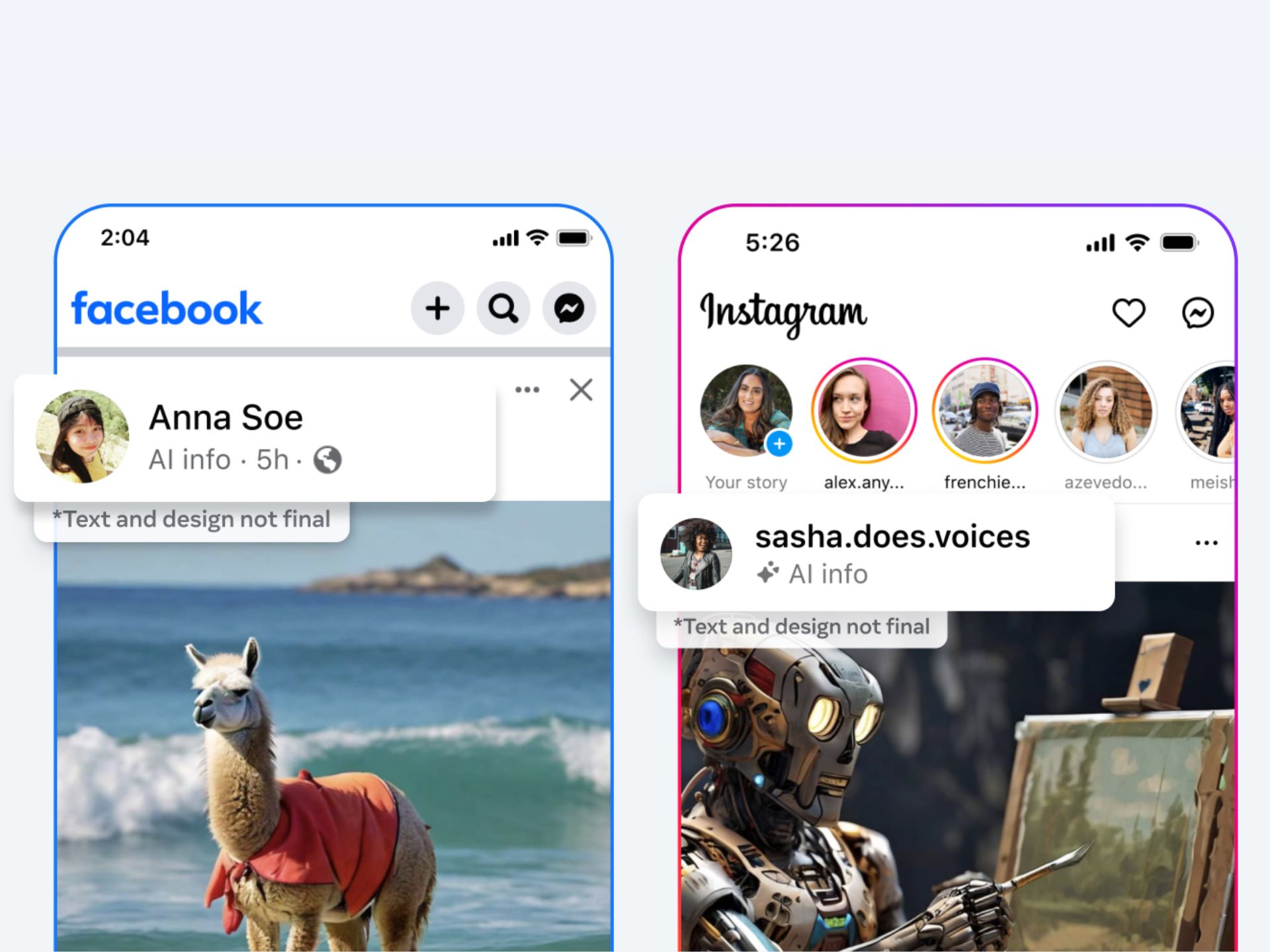

Il primo passo è etichettare le immagini AI pubblicate dagli utenti di Facebook, Instagram e Threads. Quelle create con la funzionalità proprietaria hanno già una filigrana dedicata, “Imagined with AI“, oltre ai metadati incorporati nei file stessi. Ma rendere disponibili degli standard su larga scala è l’obiettivo dell’azienda di Mark Zuckerberg, che ha annunciato di essere al lavoro per fare lo stesso anche con le immagini di Google, OpenAI, Microsoft, Adobe, Midjourney e Shutterstock.

Per i contenuti video e audio generati con gli strumenti di intelligenza artificiale, sottolinea Meta, è ancora presto per includere indizi simili con cui fare trasparenza. C’è tuttavia una nuova funzionalità in via di distribuzione di cui parla l’azienda, che permetterà direttamente agli utenti di segnalare i contenuti generati dall’AI, uno strumento che le saranno tenute a usare per la pubblicazione di contenuti siffatti, non reali, frutto di intelligenze artificiali, pena il rischio di sanzioni che, al momento, Meta non ha specificato.

“Questo lavoro (di trasparenza sui contenuti generati dalle AI, ndr) è particolarmente importante in quanto è probabile che diventi una questione sempre più conflittuale negli anni a venire. Gli utenti e le organizzazioni che vogliono ingannare le persone con contenuti generati dall’intelligenza artificiale cercheranno degli escamotage per aggirare le misure di sicurezza messe in atto per rivelarli. Dovremo perciò continuare a cercare modi per prevenirli” si legge nel comunicato stampa in questione, firmato dal presidente degli affari globali di Meta, Nick Clegg, da cui si evincono i problemi e le difficoltà che ci sono attualmente per identificare i contenuti generati dalle AI, già in gran parte difficilmente riconoscibili.

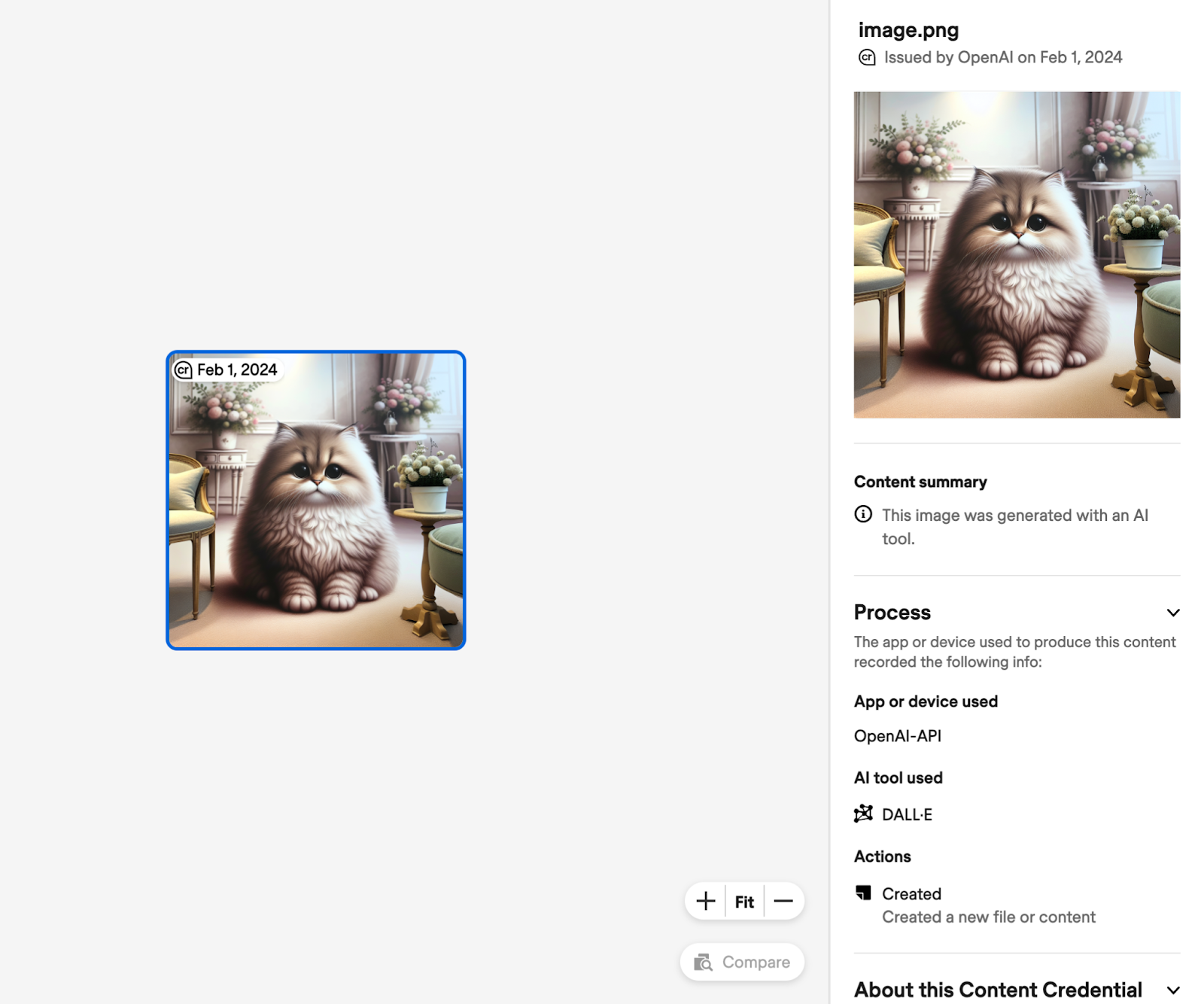

In concomitanza con l’annuncio di Meta, anche OpenAI ha annunciato che etichetterà le immagini generate da DALL-E 3 con dei metadati con cui riconoscere che si tratta di immagini generate dall’intelligenza artificiale in accordo con gli standard della Coalition for Content Provenance and Authenticity (C2PA).

Per verificare da dove provengono le immagini, è possibile ad esempio usare siti web come Content Credentials Verify. Maggiori informazioni sono reperibili in questa pagina di supporto di OpenAI.

Leggi anche: L’alternativa italiana a ChatGPT sicura, open source e di qualità: Modello Italia e Mark Zuckerberg ha grandi piani per l’Intelligenza Artificiale Generale

I nostri contenuti da non perdere:

- 🔝 Importante: Recensione TP-Link Archer NX600, il router 5G per gli "sfibrati"

- 💰 Risparmia sulla tecnologia: segui Prezzi.Tech su Telegram, il miglior canale di offerte

- 🏡 Seguici anche sul canale Telegram Offerte.Casa per sconti su prodotti di largo consumo