NVIDIA sceglie la vetrina della GTC 2024 per annunciare la GPU destinata all’AI più potente mai realizzata finora, si tratta di Blackwell B200, una soluzione a dir poco all’avanguardia che stravolge le prestazioni di categoria pur guardando all’efficienza energetica, un fattore a dir poco decisivo quando parliamo di sistemi server configurati con decine, centinaia o migliaia di GPU in parallelo.

L’arrivo di NVIDIA Blackwell B200 era già nell’aria, le indiscrezioni sono state diverse, tuttavia i dati snocciolati da NVIDIA durante la presentazione hanno a dir poco impressionato, facendo tra l’altro ben sperare in ottica futura per le GPU Next-Gen di fascia consumer. Insieme alla potentissima Blackwell B200, il produttore californiano ha annunciato anche il superchip GB200, una piattaforma completa per i sistemi destinati ai carichi AI (ma non solo), che affianca le nuovissime B200 a processori Grace in cluster configurabili. Ma vediamo tutto nel dettaglio.

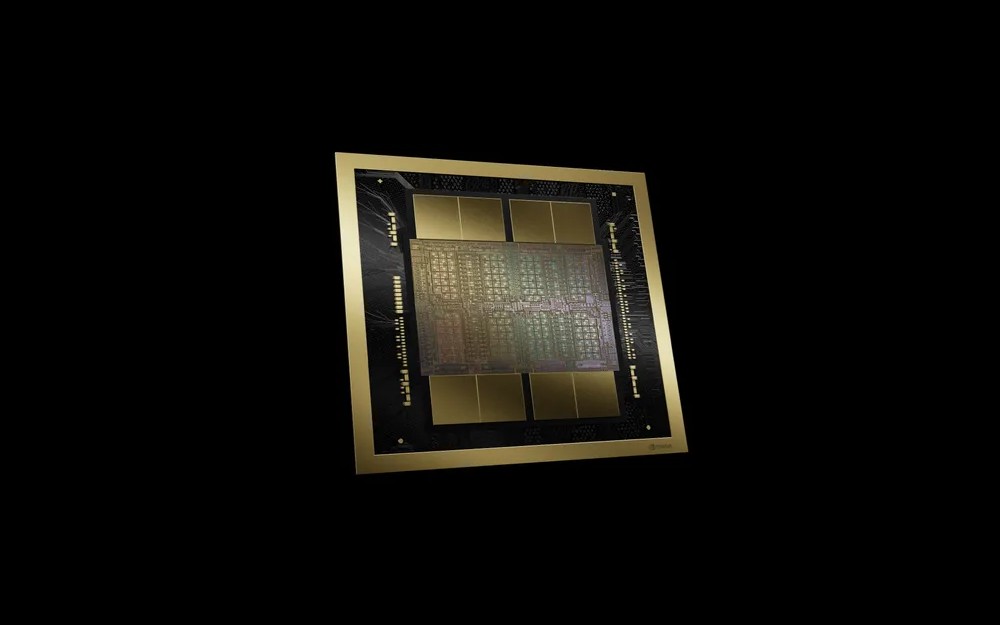

NVIDIA Blackwell B200 è un chip mostruoso da 208 miliardi di transistor

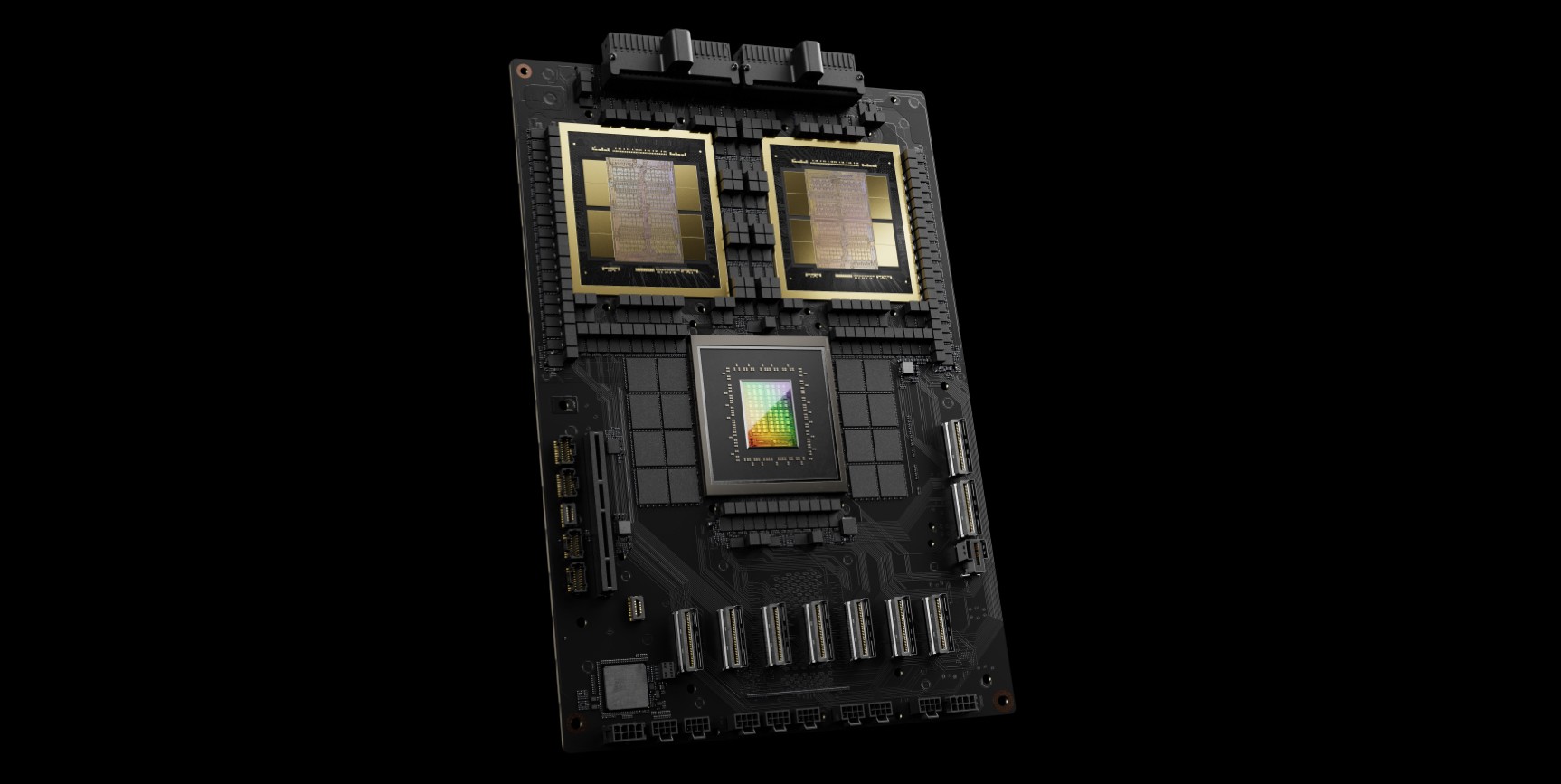

Prima di parlare di prestazioni, ribadiamo da capogiro, ricapitoliamo le specifiche tecniche condivise da NVIDIA per la GPU Blackwell B200 e il superchip GB200. Partiamo dalla GPU B200, un chip mostruoso che integra due die GPU che agiscono come una singola GPU e comunicano chip-to-chip con una larghezza di banda di 10 TB/s, il nodo produttivo in questo caso è il TSMC 4NP. Le novità introdotte con Blackwell B200 sono diverse, partendo dalla seconda generazione di Transformer Engine, passando all’interfaccia NVLink di quinta generazione a 1,8 TB/s (bidirezionale), RAS Engine dedicato, Secure AI in ottica sicurezza e Decompression Engine di ultima generazione. Con queste caratteristiche, NVIDIA Blackell B200 offre secondo l’azienda una potenza di calcolo FP4 di ben 20 PetaFLOPS; per avere un termine di paragone, due GPU B200 abbinate a una GPU Grace garantiscono prestazioni 30 volte superiori nel campo dell’inferenza LLM rispetto a NVIDIA H100, il tutto riducendo consumi e costi sino a 25 volte la precedente generazione.

NVIDIA è stata molto esaustiva nell’illustrare le peculiarità prestazionali ed energetiche di Blackwell B200, ma anche dei sistemi GB200 con CPU Grace che ne beneficeranno. Il tutto ruota ovviamente intorno all’Intelligenza Artificiale generativa che, come discusso in più occasioni, sarà (anzi è) il nuovo punto focale dell’industria tecnologica. Per fare qualche esempio in questo contesto, NVIDIA spiega che per addestrare un modello da 1,8 trilioni di parametri servivano 8.000 GPU H100 Hopper per un consumo di 15 megawatt; con Blackwell il numero di GPU scende a 2.000 con un consumo che si riduce a meno di un terzo, ovvero 4 megawatt.

Uno dei segreti di Blackwell B200 e del superchip GB200 risiede nella possibilità di sfruttare la nuova interfaccia NVLink di quinta generazione a 1,8 TB/s, capace di far comunicare sino a 576 GPU senz colli di bottiglia; si tratta di un “aggiornamento” di non poco conto che ha richiesto a NVIDIA la realizzazione di un nuovo switch più efficiente e soprattutto meno esigente in fatto di risorse di sistema. Come da tradizione, i sistemi GB200 saranno scalabili, un singolo rack GB200 NVL72 può ospitare 36 CPU e 72 GPU raffreddate a liquido con una potenza di calcolo di 720 PetaFLOPS in ambito AI training e 1,4 ExaFLOPS in campo inferenza LLM. Secondo NVIDIA, uno solo di questi sistemi è in grado di gestire modelli con 27 trilioni di parametri e, giusto per chiudere con i paragoni, pensate che GPT-4 è accreditato di 1,7 trilioni di parametri. Un vero mostro, senza giri di parole.

In chiusura, NVIDIA ha calato quello che potremmo definire un altro asso vincente; dopo il successo dei sistemi basati su Hopper H100 (ma non solo), l’azienda di Jen-Hsun Huang si prepara senza dubbio a periodi ancora migliori, se non altro perché a oggi nessuno può garantire questo livello tecnologico e prestazionale. I più grossi partner dell’azienda statunitense sicuramente non perderanno tempo per accaparrarsi i nuovi chip NVIDIA B200 e i sistemi GB200, capaci di offrire ribadiamo singoli cluster configurabili sino a 576 GPU e 288 CPU, abbinati a 240 TB di memoria e a un’interfaccia di rete sino a 800 Gbps, il tutto per un picco prestazionale di 11,5 ExaFLOPS (FP4) e possibilità di scalare fino a decine di migliaia di sistemi GB200.

Potrebbe interessarti anche Le GDDR7 sono realtà: le novità delle memorie per le GPU next-gen AMD e NVIDIA e Migliori schede video di Marzo 2024: ecco le migliori che abbiamo selezionato

I nostri contenuti da non perdere:

- 🔝 Importante: Recensione Amazfit Active Max, ci siamo davvero?

- 💰 Risparmia sulla tecnologia: segui Prezzi.Tech su Telegram, il miglior canale di offerte

- 🏡 Seguici anche sul canale Telegram Offerte.Casa per sconti su prodotti di largo consumo