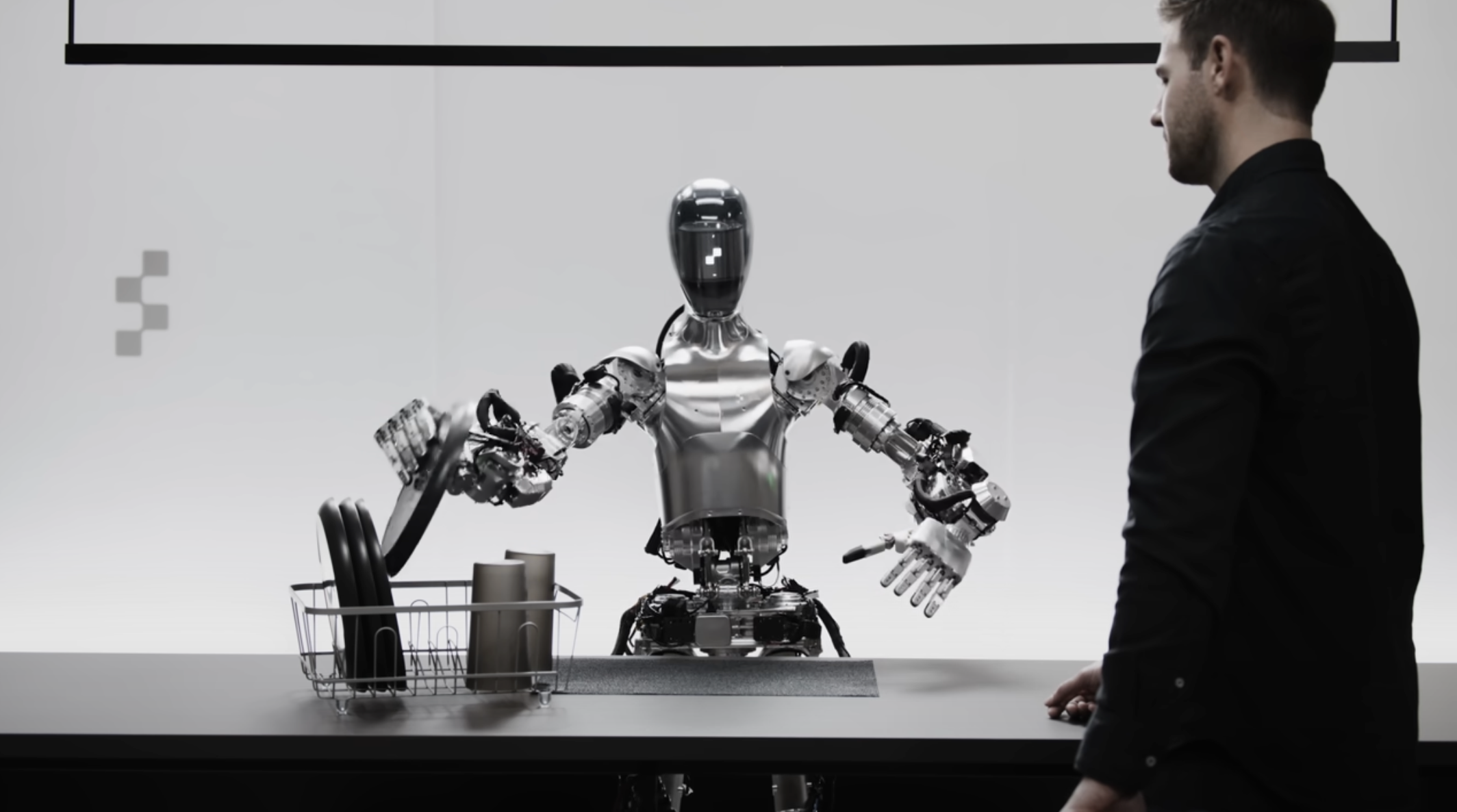

Immaginate che ChatGPT abbia un corpo. Ecco, più o meno sarebbe Figure 01, il primo robot umanoide nato dalla collaborazione tra OpenAI e Figure AI. Il progetto, che in un nuovo round di finanziamento ha recentemente raccolto 675 milioni di dollari da investitori importanti (vedi Jeff Bezos, Microsoft e NVIDIA), torna a mostrarsi con un video particolarmente impressionante per come mescola il lato meccanico, materico della robotica e quello impalpabile dell’intelligenza artificiale – corpo e anima, diremmo, se il protagonista fosse in carne ed ossa.

Due chiacchiere col robot

Figure 01 si trova di fronte ad un tavolo con diversi utensili ed una mela, ed interagisce con un essere umano. La prima richiesta che riceve è quella di descrivere lo scenario che gli si presenta davanti.

Quello che più colpisce nella risposta non è tanto la precisione con cui vengono enumerati gli oggetti, ma la naturalezza con cui il robot struttura il discorso e la credibilità della sua voce, con tanto di esitazioni (“uhm”) che aumentano l’effetto di realtà, avvicinando il robot ad un interlocutore umano. Lo zampino di OpenAI, insomma, si sente eccome.

Il risultato è così credibile (o incredibile?) che in rete c’è chi pensa sia tutto un discorso pre-registrato: dubbio puntualmente smentito dagli sviluppatori, che sottolineano come Figure 01 sia in grado di performare autonomamente nella maniera mostrata in video.

Avete mai visto un robot sparecchiare?

Per dimostrare che il robot è in grado di sintetizzare le informazioni che trae dall’ambiente circostante, c’è poi anche una prova pratica.

Figure 01 certifica anzitutto di essere fortissimo nella teoria, porgendo la mela all’utente umano che chiede se sia possibile offrirgli qualcosa da mangiare, spiegando che il frutto è stato scelto in quanto unico elemento edibile tra quelli a disposizione.

Poi gli viene chiesto come pensa dovrebbe organizzare piatti e bicchieri ora che la mela non c’è più e considerando quello che può vedere. Dal momento che lo scenario prevede anche piatti e bicchieri ordinati, Figure 01 capisce che deve sparecchiare.

Qui finisce la teoria, e arriva la prova pratica: il robot di Figure AI e OpenAI fa bella figura anche in questo senso, mettendo a posto il piatto e il bicchiere attraverso movimenti complessi eppure fluidi e piuttosto rapidi.

È importante sottolineare che non ci troviamo davanti ad una prescrizione che il robot si limita ad eseguire, ma all’esito di un processo che porta l’intelligenza artificiale che lo anima a mettere in una relazione complessa gli elementi che lo circondano, la loro funzione e il contenuto della domanda ricevuta.

Ovviamente la dimostrazione offerta nel video è creata ad arte per porre in risalto le qualità del progetto, al fine di attrarre ulteriori investimenti. Con questo non vogliamo dire che quanto mostrato sia falso, ma semplicemente che si tratta di un contesto estremamente controllato e testato, in cui il robot viene posto nelle condizioni ideali per performare al meglio, mostrando le proprie qualità principali.

Non sappiamo, ad esempio, se Figure 01 sarebbe in grado di orientarsi e comportarsi in maniera analoga in scenari diversi e più complessi di quello studiato per la demo, e se sì quanto tempo e quanti errori servirebbero. Ma ciò che hanno mostrato OpenAI e Figure AI, al netto di tutto questo, lascia comunque già a bocca aperta, e comincia a rendere concreti e vicini scenari fantascientifici.

I nostri contenuti da non perdere:

- 🔝 Importante: Recensione TP-Link Archer NX600, il router 5G per gli "sfibrati"

- 💰 Risparmia sulla tecnologia: segui Prezzi.Tech su Telegram, il miglior canale di offerte

- 🏡 Seguici anche sul canale Telegram Offerte.Casa per sconti su prodotti di largo consumo