NVIDIA ha annunciato ufficialmente l’apertura del codice sorgente di Audio2Face, la sua tecnologia di animazione facciale guidata dall’audio che negli ultimi anni ha trovato applicazione in videogiochi, intrattenimento e servizi digitali.

L’iniziativa, resa pubblica in concomitanza con il recente aggiornamento della suite ACE (Avatar Cloud Engine), punta a rendere accessibile a sviluppatori, ricercatori e studenti uno strumento avanzato per generare avatar 3D realistici, dotati di sincronizzazione labiale accurata ed espressioni emotive naturali.

Si tratta di un passo significativo per accelerare l’adozione di avatar intelligenti e interattivi in numerosi settori, dalla customer experience al gaming, passando per la creazione di contenuti multimediali.

Indice:

Cos’è NVIDIA Audio2Face

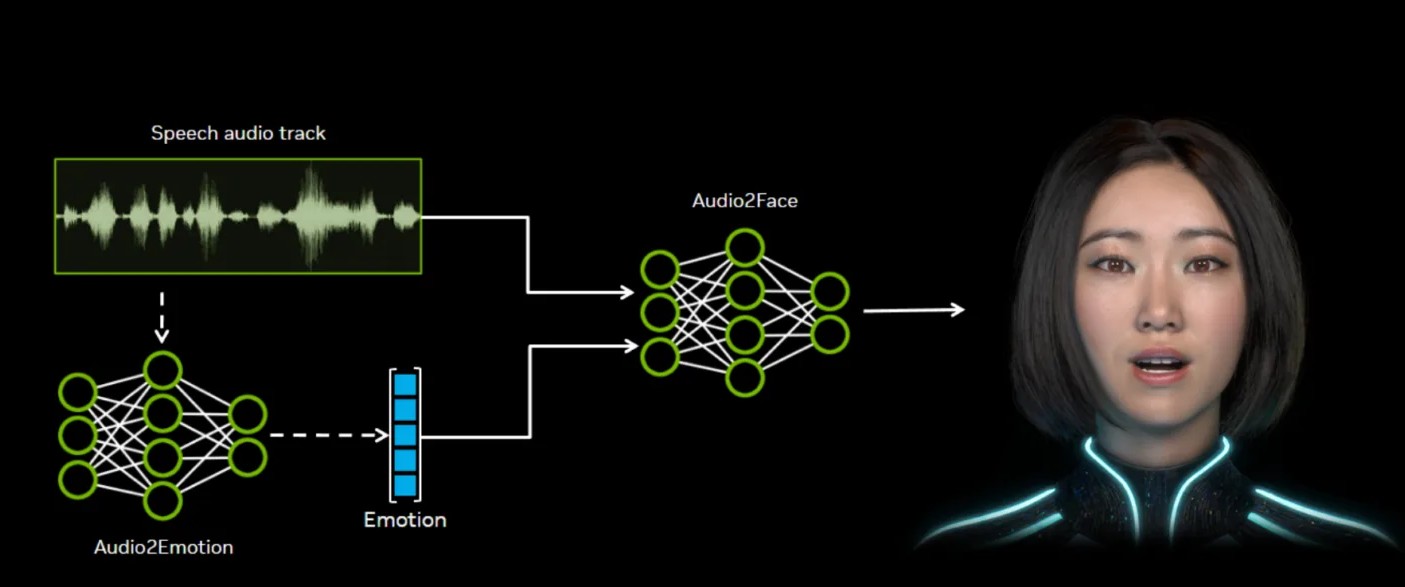

Audio2Face è una tecnologia basata su modelli di Intelligenza Artificiale generativa che trasforma una traccia audio in animazioni facciali realistiche e dinamiche. Il sistema analizza le caratteristiche acustiche di una voce – dai fonemi all’intonazione – e le converte in una sequenza di pose facciali, permettendo a un personaggio 3D di muovere labbra, occhi e tratti del volto in maniera credibile e coerente con il parlato.

Questa pipeline può essere utilizzata sia in modalità offline, ad esempio per scene pre-renderizzate, sia in tempo reale per interazioni dinamiche, come nel caso di NPC nei videogiochi o assistenti virtuali in applicazioni di servizio al cliente.

La novità principale annunciata da NVIDIA è l’apertura del codice, che non riguarda soltanto i modelli già addestrati ma anche l’SDK, i plugin per software di sviluppo 3D e il framework di training. In questo modo ogni sviluppatore può adottare Audio2Face così com’è, oppure personalizzarlo e addestrarlo su dati specifici per ottenere animazioni facciali su misura.

Strumenti open source e modelli disponibili

Il pacchetto open source comprende diversi strumenti. L’Audio2Face SDK mette a disposizione librerie e documentazione per integrare l’animazione facciale in applicazioni locali o basate sul cloud. A questo si affiancano i plugin dedicati: uno per Autodesk Maya (v2.0) e uno per Unreal Engine 5 (v2.5, compatibile con UE 5.5 e 5.6), che consentono di inviare input audio e ricevere in output animazioni facciali direttamente all’interno dei motori di sviluppo più utilizzati dall’industria.

Completa l’offerta il Training Framework (v1.0), che permette di creare nuovi modelli Audio2Face usando dataset personalizzati. Sul fronte dei modelli, NVIDIA ha reso disponibili sia i modelli di regressione (v2.2) sia i più recenti modelli di diffusione (v3.0), capaci di generare lip-sync ancora più realistici.

Accanto a questi sono inclusi gli Audio2Emotion Models, che stimano lo stato emotivo di un parlato: una versione di produzione (v2.2) e una sperimentale (v3.0). Per chi vuole iniziare a sperimentare senza dati propri è disponibile anche un set di training sample data.

Adozione nell’industria ed esempi pratici

Audio2Face non è un esperimento di laboratorio, infatti è già ampiamente utilizzato da studi di sviluppo e aziende del settore. Codemasters lo ha integrato in F1 25 per aumentare il realismo dei personaggi, mentre realtà come Reallusion l’hanno incluso nei propri strumenti di creazione di avatar, come iClone e Character Creator.

Reallusion sottolinea come la combinazione con strumenti avanzati di editing facciale renda la produzione di animazioni più accessibile e rapida. Anche Survios, con il titolo Alien: Rogue Incursion Evolved Edition, ha beneficiato dell’integrazione, velocizzando il processo di lip-sync e motion capture per offrire ai giocatori un’esperienza più immersiva.

The Farm 51, sviluppatore della serie Chernobylite, ha definito Audio2Face un vero “game-changer”, capace di ridurre drasticamente i tempi di animazione e portare un livello di dettaglio prima irraggiungibile.

Tecnologie complementari: RTX Kit e vGPU

Parallelamente, NVIDIA ha aggiornato anche altre tecnologie collegate al mondo dello sviluppo videoludico. L’RTX Kit, che racchiude strumenti di neural rendering per ray tracing, gestione delle texture e illuminazione globale, ha ricevuto ottimizzazioni significative, comprese librerie più efficienti e nuove opzioni per sviluppatori.

Sul versante infrastrutturale, la tecnologia NVIDIA vGPU ha permesso ad Activision di ridurre drasticamente il numero di server utilizzati per lo sviluppo, passando da 100 macchine legacy a 6 unità basate su GPU RTX. Questo ha portato un abbattimento dell’82% dell’ingombro e del 72% dei consumi, oltre a una pipeline di test e distribuzione molto più rapida.

Infine, durante il SIGGRAPH 2025, NVIDIA ha mostrato gli ultimi miglioramenti agli strumenti della suite Nsight, pensati per ottimizzare performance e debug nelle applicazioni di ray tracing. Le sessioni di training, ora disponibili on-demand, spaziano dal profiling degli shader alla gestione della VRAM, fornendo ai team di sviluppo strumenti concreti per migliorare qualità e prestazioni dei loro progetti.

In conclusione, con l’apertura del codice di Audio2Face, NVIDIA compie un passo decisivo verso l’apertura su ampia scala dell’animazione facciale AI-driven. Rendere disponibili SDK, plugin, modelli pre-addestrati e framework di training significa dare a sviluppatori e creatori la possibilità di costruire avatar sempre più realistici e personalizzati, riducendo costi e tempi di produzione.

I nostri contenuti da non perdere:

- 🔝 Importante: Recensione ASUS ExpertBook Ultra: la vera sorpresa tra i notebook con Intel Core Panther Lake

- 🚨 I migliori Notebook MSI Prestige, adatti per ogni esigenza

- 💻 La prova di Reolink Home Hub: un sistema di video-sorveglianza in locale, affidabile ed economico

- 💰 Risparmia sulla tecnologia: segui Prezzi.Tech su Telegram, il miglior canale di offerte

- 🏡 Seguici anche sul canale Telegram Offerte.Casa per sconti su prodotti di largo consumo