Il lancio di GPT-5, presentato come il modello AI più avanzato, utile e intelligente di OpenAI, non è stato accolto nel migliore dei modi. Durante una sessione Ask Me Anything (AMA) su Reddit con il CEO di OpenAI, Sam Altman e alcuni ingegneri dell’azienda, diversi utenti hanno sollevato diverse critiche, tanto che l’azienda è dovuta correre ai ripari ripristinando alcune precedenti versioni.

Tutto quello che non ha funzionato

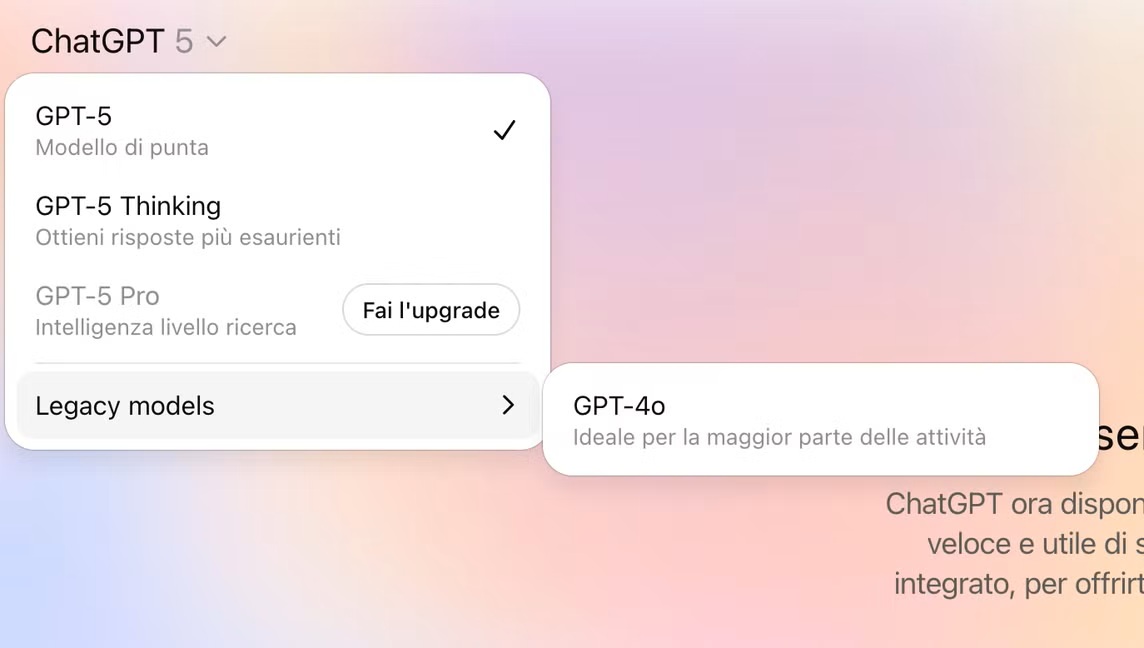

Le principali lamentele hanno riguardato soprattutto la rimozione di GPT-4o e GPT-4.1, modelli che gli utenti considerano più versatili e in grado di fornire risposte più naturali. GPT-5, invece, è stato percepito come più freddo e meno adatto all’uso quotidiano, mentre GPT-4o era apprezzato per il suo equilibrio tra semplicità d’uso e capacità di affrontare compiti più complessi. Da questo punto di vista è interessante notare come GPT-5 sia stato presentato come più umano e meno soggetto alle adulazioni, ma la percezione degli utenti non è stata così positiva.

Inoltre, l’abbandono di GPT-4.1 ha comportato anche la scomparsa della possibilità di lavorare con una finestra di contesto da un milione di token, una funzione molto apprezzata in scenari avanzati. A peggiorare la situazione, il lancio di GPT-5 è avvenuto senza che i modelli “mini”, pensati per subentrare quando si esauriscono i messaggi disponibili per il modello principale, fossero pronti all’uso. In più, l’autoswitcher, ovvero il sistema che sceglie automaticamente il modello più adatto alla richiesta dell’utente, ha funzionato male, facendo apparire GPT-5 meno capace del previsto.

Il dietrofront di OpenAI

Con il montare delle polemiche della community, OpenAI ha deciso di ripristinare GPT-4o (seppur come modello “legacy” da attivare nelle impostazioni di ChatGPT). Il vecchio modello, quindi, tornerà a disposizione degli utenti con un piano Plus e Team su tutte le piattaforme. La società ha inoltre annunciato che la prossima settimana saranno disponibili le versioni mini di GPT-5 e GPT-5 Thinking, assenti al momento del debutto, per evitare interruzioni quando si raggiungono i limiti di utilizzo.

A few GPT-5 updates heading into the weekend:

– Now rolled out to 100% of Plus, Pro, Team, and Free users

– We’ve finished implementing 2x rate limits for Plus and Team for the weekend; next week we’re rolling out mini versions of GPT-5 & GPT-5 thinking to take over until your…

— OpenAI (@OpenAI) August 9, 2025

Un altro cambiamento riguarda la trasparenza. OpenAI ha dichiarato di impegnarsi a indicare in modo chiaro quale modello sta rispondendo a una determinata richiesta, così da eliminare ogni dubbio sulla tecnologia effettivamente in uso. Nel frattempo sono entrati in vigore limiti più restrittivi per gli utenti a pagamento. Gli utenti con abbonamento Plus o Team hanno ora un limite doppio rispetto a quello base, ma comunque inferiore rispetto al passato, quando GPT-4o era accessibile senza restrizioni.

La stessa OpenAI ha ammesso che per ora GPT-5 non offre una finestra di contesto lunga come quella di GPT-4.1, principalmente per ragioni di costo computazionale. Sam Altman ha assicurato che il modello migliorerà e ha invitato a considerare questa fase come un passaggio intermedio verso prestazioni più avanzate.

GPT-5 rollout updates:

*We are going to double GPT-5 rate limits for ChatGPT Plus users as we finish rollout.

*We will let Plus users choose to continue to use 4o. We will watch usage as we think about how long to offer legacy models for.

*GPT-5 will seem smarter starting…

— Sam Altman (@sama) August 8, 2025

La vicenda ha però evidenziato non solo la necessità per le aziende di ascoltare la community, ma anche di procedere con attenzione nei cambiamenti in quanto la continuità nelle funzioni più apprezzate è considerata un valore. Qualche mese fa qualcosa di simile è accaduto con Spotify che ha ricevuto numerose critiche da parte dei propri utenti per l’aggiunta di un tasto. Inoltre, iniziano a emergere sempre più chiaramente i problemi di sostenibilità dei sistemi di intelligenza artificiale. Per ora GPT-5 non offre una finestra di contesto come quella di GPT-4.1 per ragioni di costi. Permettere a GPT-5 di avere una finestra di contesto da un milione di token, infatti, significa che il modello deve elaborare una quantità enorme di testo per ogni richiesta. Questo comporta l’uso di server più potenti, più memoria e più tempo di elaborazione, con un conseguente aumento dei costi energetici e di infrastruttura. Siamo ancora all’inizio della diffusione di questi sistemi AI e non è da escludere che la loro sostenibilità, come già evidenziato da molti, possa risultare un elemento dirimente per il loro successo futuro.

I nostri contenuti da non perdere:

- 🔝 Importante: Sottili e potenti, c’è un notebook per tutti con i nuovi MSI Prestige AI con Intel® Core™ Ultra: guida all’acquisto

- 🚨 I migliori Notebook MSI Prestige, adatti per ogni esigenza

- 💻 La prova di Reolink Home Hub: un sistema di video-sorveglianza in locale, affidabile ed economico

- 💰 Risparmia sulla tecnologia: segui Prezzi.Tech su Telegram, il miglior canale di offerte

- 🏡 Seguici anche sul canale Telegram Offerte.Casa per sconti su prodotti di largo consumo