I ricercatori Microsoft stanno sperimentando un modello di intelligenza artificiale in grado di far parlare una foto o un’immagine di un volto.

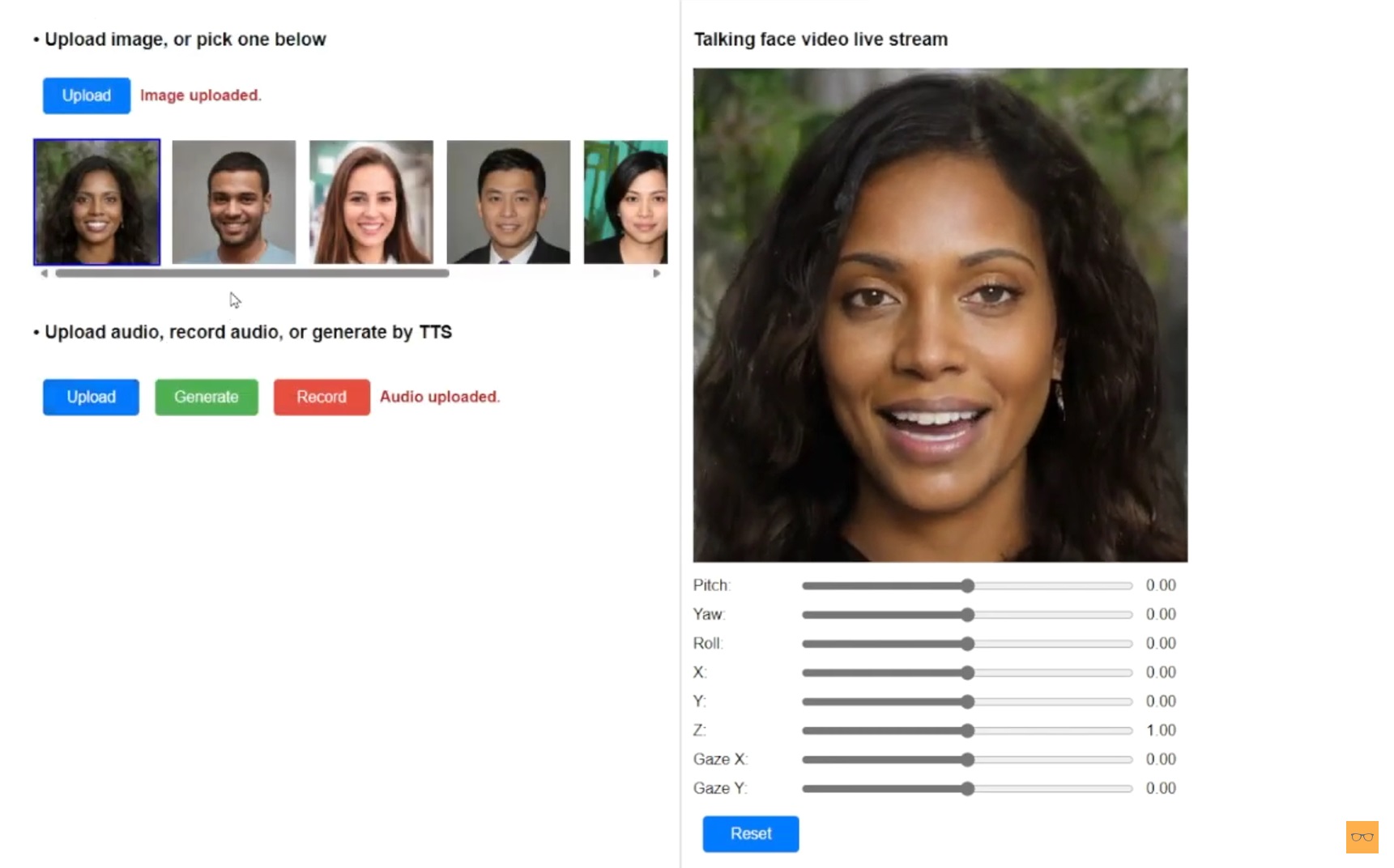

VASA-1 acquisisce una singola foto di un ritratto e un file audio e lo converte in un video iperrealistico di un volto parlante completo di sincronizzazione labiale, animazione del viso e movimenti della testa.

Qualcosa di simile è già disponibile attraverso Runway e NVIDIA, ma lo strumento di Microsoft sembra essere di qualità e realismo molto più elevati, soprattutto per quanto riguarda la sincronizzazione labiale dagli artefatti quasi impercettibili.

Novità! DREAME L10s Ultra Gen 3

Kit Robot Aspirapolvere e Lavapavimenti, Aspirazione da 25.000 Pa, Spazzola

VASA-1 di Microsoft sembra molto potente e versatile

Microsoft afferma che si tratta di un nuovo framework per la creazione di volti parlanti realistici progettati con lo scopo di animare personaggi virtuali, ma ovviamente può animare anche una foto reale.

I movimenti sono leggermente a scatti ma nel complesso hanno un’aspetto naturale, inoltre VASA-1 sembra capace di comprendere la direzione dello sguardo, la distanza della testa e persino l’emozione del parlato come input per guidare la generazione del video.

Uno dei casi d’uso più ovvi è la sincronizzazione labiale avanzata per i videogiochi, ma il modello potrebbe anche essere utilizzato per creare avatar virtuali per i video dei social, come già possibile tramite strumenti come HeyGen e Synthesia.

VASA-1 potrebbe anche andare oltre, come realizzare un video musicale con un cantante AI particolarmente realistico, infatti i ricercatori sono rimasti sorpresi dalla capacità di VASA-1 di sincronizzarsi perfettamente con una canzone, riflettendo le parole del cantante senza problemi nonostante non fosse utilizzata musica nel set di dati di addestramento.

Il modello è riuscito a creare immagini da 512×512 pixel a 45 fotogrammi al secondo in circa 2 minuti utilizzando una GPU NVIDIA RTX 4090.

Il team afferma che si tratta solo di una dimostrazione di ricerca, senza piani per un rilascio pubblico o aziendale, ma dato che Microsoft è direttamente collegata a OpenAI, questo potrebbe anche far parte di una futura integrazione di Sora in Copilot. Ecco una dimostrazione del tool VASA-1.

I nostri contenuti da non perdere:

- 🔝 Importante: Recensione Roborock Saros 20: lavaggio a 100°, 36.000 Pa di aspirazione e cura nei dettagli

- 💰 Risparmia sulla tecnologia: segui Prezzi.Tech su Telegram, il miglior canale di offerte

- 🏡 Seguici anche sul canale Telegram Offerte.Casa per sconti su prodotti di largo consumo