Nella giornata di oggi, 2 agosto 2023, è arrivato un altro annuncio in tema di intelligenza artificiale da parte di Meta: AudioCraft è il nuovo codice open-source che permette agli utenti di creare musica e suoni attraverso un connubio di input testuali e AI generativa.

Meta AudioCraft: tre modelli per creare musica con l’AI

Nelle ultime settimane, abbiamo affrontato a più riprese il tema dell’intelligenza artificiale in relazione a Meta: dalla presentazione di Voicebox al modo in cui l’AI entra in gioco per selezionare i contenuti che vediamo su Facebook e Instagram, passando per la creazione di Llama 2 in collaborazione con Microsoft. Quest’oggi parliamo di AudioCraft e di come sia possibile creare musica grazie all’AI generativa.

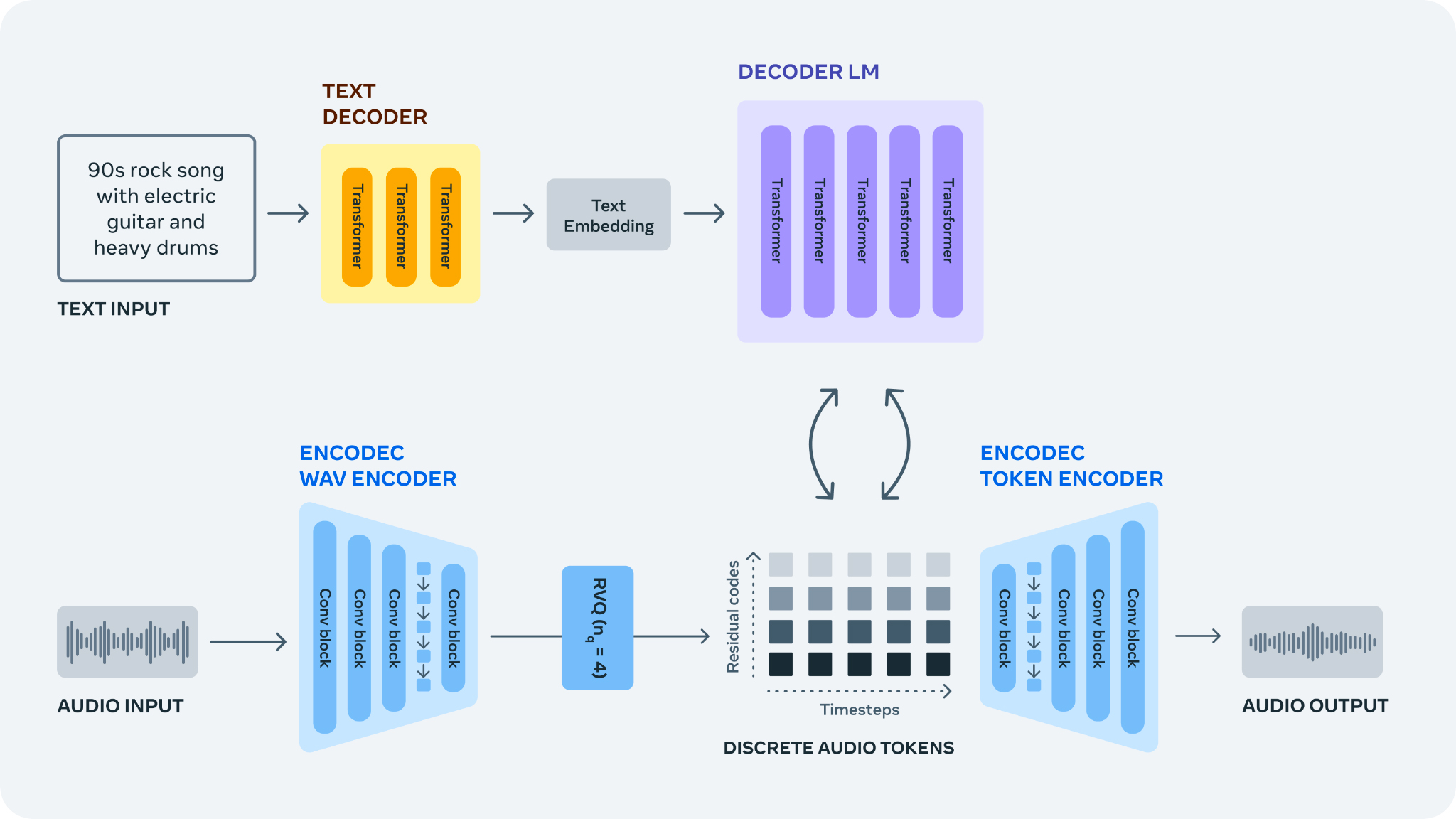

Nel complesso, parliamo di tre modelli AI che si occupano di tre diverse aree della generazione di suoni. Il primo modello, MusicGen, riceve input testuali e li utilizza per generare della musica. Meta parla di questo modello ponendo l’accento sull’addestramento condotto su oltre 20.000 ore di musica posseduta da Meta stessa o in licenza per questo preciso scopo. Passando oltre, AudioGen è stato addestrato servendosi di effetti sonori pubblici ed è in grado di generare suoni a partire da suggerimenti scritti, arrivando così ad imitare cani che abbaiano, il rumore di passi e quant’altro. In sede di annuncio, Meta ha ricordato il ruolo di una versione aggiornata e migliorata del suo codec EnCoder, che promette di ridurre gli artefatti nei suoni creati per gli utenti.

Gradite qualche dimostrazione pratica di musica e suoni creati da AudioCraft? Ebbene, Meta ha corredato l’annuncio dei seguenti sample: ciascuno di essi riporta nel titolo l’input testuale che è stato fornito al modello di AI per addivenire alla creazione della traccia audio.

Meta, comunque non è né l’unico né il primo produttore a mettere insieme musica ed intelligenza artificiale: i più attenti tra di voi ricorderanno sicuramente MusicLM di Google.

Allo stato attuale, AudioCraft appare come uno strumento che potrebbe essere impiegato al massimo per la creazione di suoni semplici o per qualche traccia di sottofondo, più che per rubare la scena a qualche star mondiale della musica pop. Ad ogni modo, Meta ha le idee chiare per il futuro: pensa che MusicGen abbia le carte in regola per diventare un nuovo strumento tra le mani di creativi e musicisti, un po’ come i primi synth.

In aggiunta a questo, Meta ha riconosciuto la necessità di approcciarsi a strumenti di questo tipo con senso di responsabilità e trasparenza; alla luce di ciò, ha subito ammesso la mancanza di diversità nei dataset utilizzati per l’addestramento dei modelli di AI, che non vanno oltre lo stile musicale occidentale e la lingua inglese. Del resto, progetti di questo tipo hanno bisogno di essere open-source perché — come dice Meta — “L’innovazione responsabile non può avvenire in modo isolato. Rendere la nostra ricerca e i modelli che ne sono scaturiti open source aiuta a garantire che tutti possano accedervi in condizioni di parità”.

Potrebbe interessarti anche: WhatsApp, Instagram e Facebook dovrebbero integrare a breve gli “assistenti IA”

I nostri contenuti da non perdere:

- 🔝 Importante: Abbiamo provato una stampante laser a colori economica per un anno e non torneremmo più indietro (video)

- 💰 Risparmia sulla tecnologia: segui Prezzi.Tech su Telegram, il miglior canale di offerte

- 🏡 Seguici anche sul canale Telegram Offerte.Casa per sconti su prodotti di largo consumo