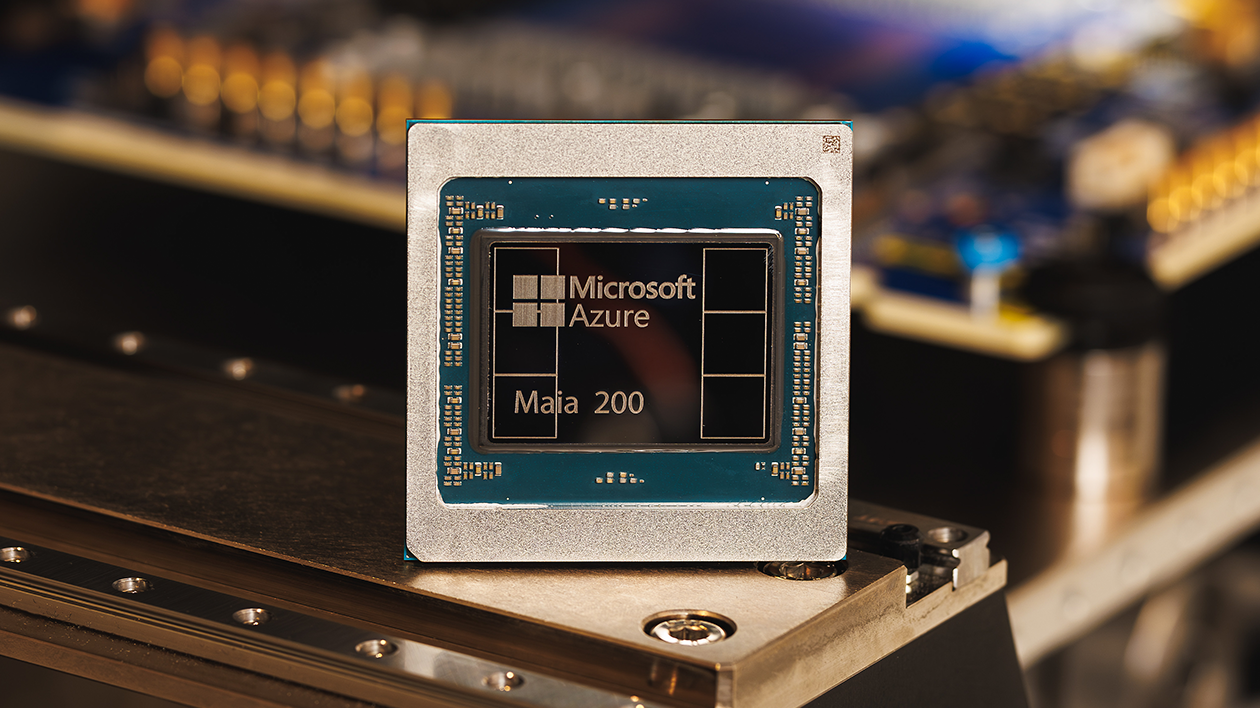

Con un comunicato stampa ufficiale, nelle scorse ore Microsoft ha presentato ufficialmente il suo nuovo acceleratore AI Azure Maia 200, un chip destinato e ottimizzato soprattutto per l’inferenza che arriva sul mercato con ambizioni molto alte, ovvero competere con i maggiori attori di settore: da Amazon, passando a Google e anche NVIDIA.

Azure Maia 200 arriva anche e soprattutto per migliorare le prestazioni e l’efficacia in campo inferenza AI del suo predecessore (Azure Maia 100), risultando secondo Microsoft fino al 30% più veloce. Ma cerchiamo di scoprire qualche dettaglio in più.

Microsoft Azure Maia 200: batte Amazon e mira a NVIDIA Blackwell

La gamma di GPU server Microsoft Maia si evolve e con Azure Maia 200 porta le prestazioni a un livello nettamente superiore al passato, o per essere più chiari, rispetto alla precedente generazione. Andando nel dettaglio, Maia 200 è realizzata su nodo produttivo TSMC 3nm, un chip da 140 miliardi di transistor che stando al produttore garantisce fino al 30% in più di performance per dollaro, elemento di primaria quando parliamo di sistemi e server realizzati per l’AI.

Stando sempre ai dati ufficiali, Maia 200 garantisce una potenza di calcolo pari a 10 petaflops FP4, supportato da un sottosistema memoria notevole: 216 GB di HBM3e con una banda a 7 TB/s a cui si abbinano ulteriori 272 MB di cache DRAM on-die. Per avere un termine di paragone, AWS Trainium3 di Amazon si ferma a 2,5 petaflops e 4,9 TB/s (144 GB HBM3e) mentre NVIDIA Blackwell B300 Ultra tocca i 15 petaflops, pareggiando anche nei calcoli FP8 (circa 5 petaflops) e nella larghezza di banda (8 vs 7 TB/s).

L’incremento prestazionale dichiarato da Microsoft bilancia se vogliamo anche il netto aumento del TDP rispetto a Maia 100, bel il 50% visto i 750 watt dichiarati per Maia 200; allo stesso tempo, il consumo del chip Microsoft risulta quasi la metà di NVIDIA Blackwell che, allo stesso tempo, è ancora imbattuto dai competitor.

In chiusura, le prestazioni e l’efficienza dichiarata da Microsoft per Maia 200 non sono affatto male, tuttavia in questi ambiti contano molto i dati “concreti” e soprattutto un bacino d’utenza consistente che possa confermare e riprodurre quanto dichiarato dal produttore, in particolare per fare un confronto rispetto alla precedente generazione di chip Maia 100.

Intanto Maia 200 ha già trovato impiego nel datacenter US Centra Azure con altri progetti in fase di partenza, ovvero appena saranno disponibili in volumi consistenti.

I nostri contenuti da non perdere:

- 🔝 Importante: Recensione TP-Link Archer NX600, il router 5G per gli "sfibrati"

- 💰 Risparmia sulla tecnologia: segui Prezzi.Tech su Telegram, il miglior canale di offerte

- 🏡 Seguici anche sul canale Telegram Offerte.Casa per sconti su prodotti di largo consumo