Prosegue la guerra contro il deepfake, la tecnica che sfrutta l’intelligenza artificiale al fine di sovrapporre in un video il volto di una persona a quello di un’altra. Stavolta è Google ad optare per la messa al bando dei progetti deepfake sul suo servizio Colaboratory (Colab), ponendo in tal modo fine all’utilizzo su larga scala delle risorse della piattaforma per questo scopo.

Si tratta di un altro serio colpo per una tecnica la quale sta destando sempre maggior allarme nel mondo politico, ma anche finanziario, in quanto può indurre gli utenti a pensare che quanto stanno vedendo sia vero. Già Facebook aveva proceduto all’inizio del 2020 alla rimozione dei video creati in tal modo, proprio per evitare una plateale e pericolosa distorsione della realtà.

Decisioni analoghe sono peraltro già state prese da diversi stati americani, a partire dalla California, ove sono stati approvati due progetti di legge che rendono illegali alcune pratiche del Deepfake. In particolare, la legge AB-602 vieta l’uso di immagini umane sintetiche al fine di originare pornografia senza il consenso della persona interessata, mentre quella AB-730 proibisce la possibile manipolazione delle immagini di candidati politici a meno di sessanta giorni dalle tornate elettorali in cui sono parte in causa.

Anche il governo cinese e l’Unione Europea si stanno dal canto loro muovendo per porre un argine alla pratica ed evitare che possa trasformarsi in una minaccia alla vita democratica e finanziaria. Andiamo quindi a vedere meglio cosa stia accadendo.

La decisione di Google

Google ha vietato la formazione di sistemi di intelligenza artificiale in grado di essere utilizzati al fine di generare deepfake sulla sua piattaforma Google Colaboratory. L’operazione è stata condotta con la massima discrezione, tramite l’aggiornamento dei termini di utilizzo di Colab, i quali ora includono questo genere di lavori nell’elenco dei progetti vietati.

Colaboratory è un progetto di ricerca nato all’interno di Google alla fine del 2017, progettato per consentire a chiunque lo voglia di scrivere ed eseguire codice Python tramite un browser Web. L’azienda fornisce agli utenti Colab l’accesso all’hardware, comprese le GPU e le unità di elaborazione del tensore (TPU) con accelerazione dell’IA progettate su misura da Google.

Nel corso degli ultimi anni è diventata di fatto la piattaforma per le demo all’interno della comunità di ricerca sull’IA, anche perché Google non ha imposto particolari restrizioni per la sua utilizzazione. Ora, però, la situazione sembra essere mutata radicalmente, come hanno appreso gli utenti del generatore di deepfake open source DeepFaceLab alla fine di maggio. Chi ha provato ad eseguire DeepFaceLab su Colab si è infatti trovato di fronte un avviso che rimandava alle FAQ, alla sezione delle azioni vietate.

Cos’è il deepfake

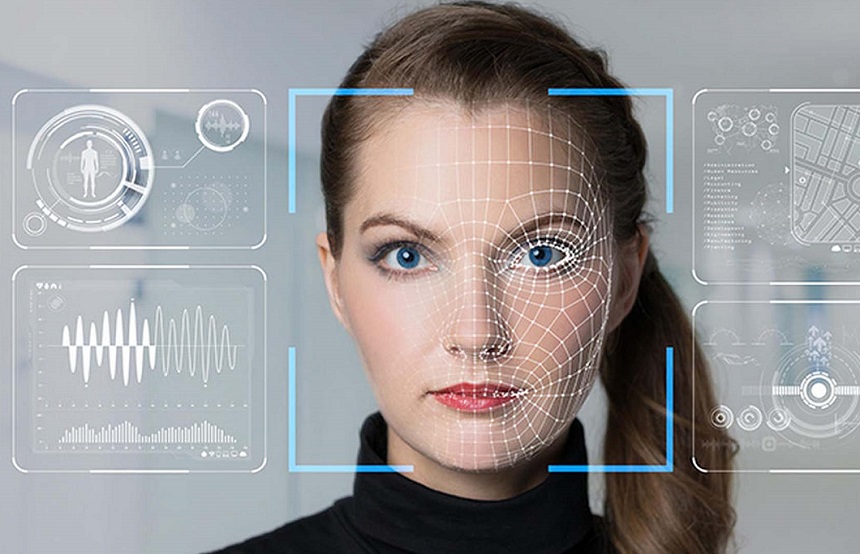

Con il termine deepfake si indica la tecnica in grado di sfruttare l’intelligenza artificiale andando in tal modo a sovrapporre il volto di una persona ad un’altra ripresa in un video. In pratica, utilizzandola si possono sostituire i volti di due persone (face swapping) e manipolare i video sino a far dire a chiunque ciò che si vuole, tramite la riproduzione della voce e la sincronizzazione del labiale. Come si può facilmente immaginare, il video taroccato diventa impossibile da distinguere rispetto ad uno autentico.

In origine il termine era riferiva a un software molto popolare su Reddit, il quale riusciva a sostituire il volto di una persona all’interno di un video venendo utilizzato quasi esclusivamente per la creazione di porno non consensuali che vedevano protagoniste alcune celebrità. Secondo le stime addirittura il 96% di questi progetti sono nati in un ambito pornografico, nell’evidente intento di ricattare i destinatari.

Da qui al crimine informatico in ambito finanziario il salto è stato breve, come dimostra quanto accaduto in Inghilterra, ove un deepfake vocale è stato utilizzato al fine di ingannare le aziende e spingerle a trasferire fondi ai truffatori, fingendosi funzionari delle rispettive società. Ancora più clamoroso il caso che ha interessato Elon Musk, protagonista di una falsa intervista utilizzata al fine di incoraggiare i suoi tanti seguaci a partecipare ad un progetto crypto, naturalmente truffaldino.

Segui Google Italia su Telegram, ricevi news e offerte per primo

Perché il bando al deepfake

La decisione di Google è praticamente una presa d’atto della pericolosità del deepfake. Se un tempo si usava Photoshop per generare deepfake, ora la palla è passata all’intelligenza artificiale, dando vita a risultati eccellenti, in grado di corrispondere ai movimenti del corpo, alle microespressioni e alle tonalità della pelle di una persona con esiti migliori addirittura rispetto a quelli ottenuti da Hollywood con le immagini ritoccate al computer.

Per capire la vastità del fenomeno basta un semplice dato: tra il 2019 e il 2021 il numero di deepfake online è cresciuto da circa 14.000 a 145.000. Forrester Research ha inoltre pronosticato nell’ottobre 2019 che le truffe fraudolente portate avanti con il deepfake sarebbero costate 250 milioni entro la fine del 2020.

I consigli di Kaspersky

Anche le case di cyber-security si sono attivate contro il deepfake. A partire da Kaspersky, i cui esperti hanno rilasciato alcuni suggerimenti da tenere presenti per provare a difendersi da una plateale distorsione della realtà che può in definitiva risultare pericolosa per le ragioni che abbiamo ricordato.

Gli esperti dell’azienda hanno in particolare ricordato che i video ritoccati e utilizzati per le truffe tendono ancora a essere di scarsa qualità, aiutando in definitiva nella loro individuazione. Ad esempio sono caratterizzati dai movimenti innaturali, dal mutamento dell’illuminazione da un fotogramma all’altro, dalla mancata sincronizzazione delle labbra con il parlato, dallo scarso o assente battito di ciglia o da un colorito dell’epidermide che muta.

Per una persona non avvezza a questo genere di valutazioni, però, non è comunque facile riuscire nell’impresa, mentre chi ha una certa dimestichezza con le tecnologie di ultima generazione può fare ricorso ad alcuni programmi creati espressamente per rallentare gli algoritmi deepfake e ridurre la qualità dei risultati.

Al resto dovranno naturalmente pensare le leggi, considerato come ormai il deepfake rappresenti uno strumento estremamente potente in mano a criminali di vario genere, come dimostra l’utilizzo sotto forma di porno revenge o per frodi finanziarie sempre più creative.

Leggi anche: Deepfake, le bufale 2.0 alimentate dall’intelligenza artificiale, cosa sono e come riconoscerli

I nostri contenuti da non perdere:

- 🔝 Importante: Recensione TP-Link Archer NX600, il router 5G per gli "sfibrati"

- 💰 Risparmia sulla tecnologia: segui Prezzi.Tech su Telegram, il miglior canale di offerte

- 🏡 Seguici anche sul canale Telegram Offerte.Casa per sconti su prodotti di largo consumo