C’era una volta un curriculum perfetto. Ottimi voti, esperienza internazionale, lettere di referenza. Eppure, nessuna chiamata. Il motivo? Un algoritmo di selezione del personale, addestrato su dati storici che penalizzavano inconsapevolmente le candidate donne e i nomi non anglosassoni.

Non è un caso isolato: nel 2018 Amazon si trovò costretta a dismettere un sistema di recruiting che discriminava sistematicamente le donne per posizioni tecniche. Il modello era stato addestrato su dieci anni di CV aziendali, in prevalenza maschili, riflettendo una cultura già sbilanciata. L’AI, in quel contesto, non fece altro che replicare e amplificare un pregiudizio esistente.

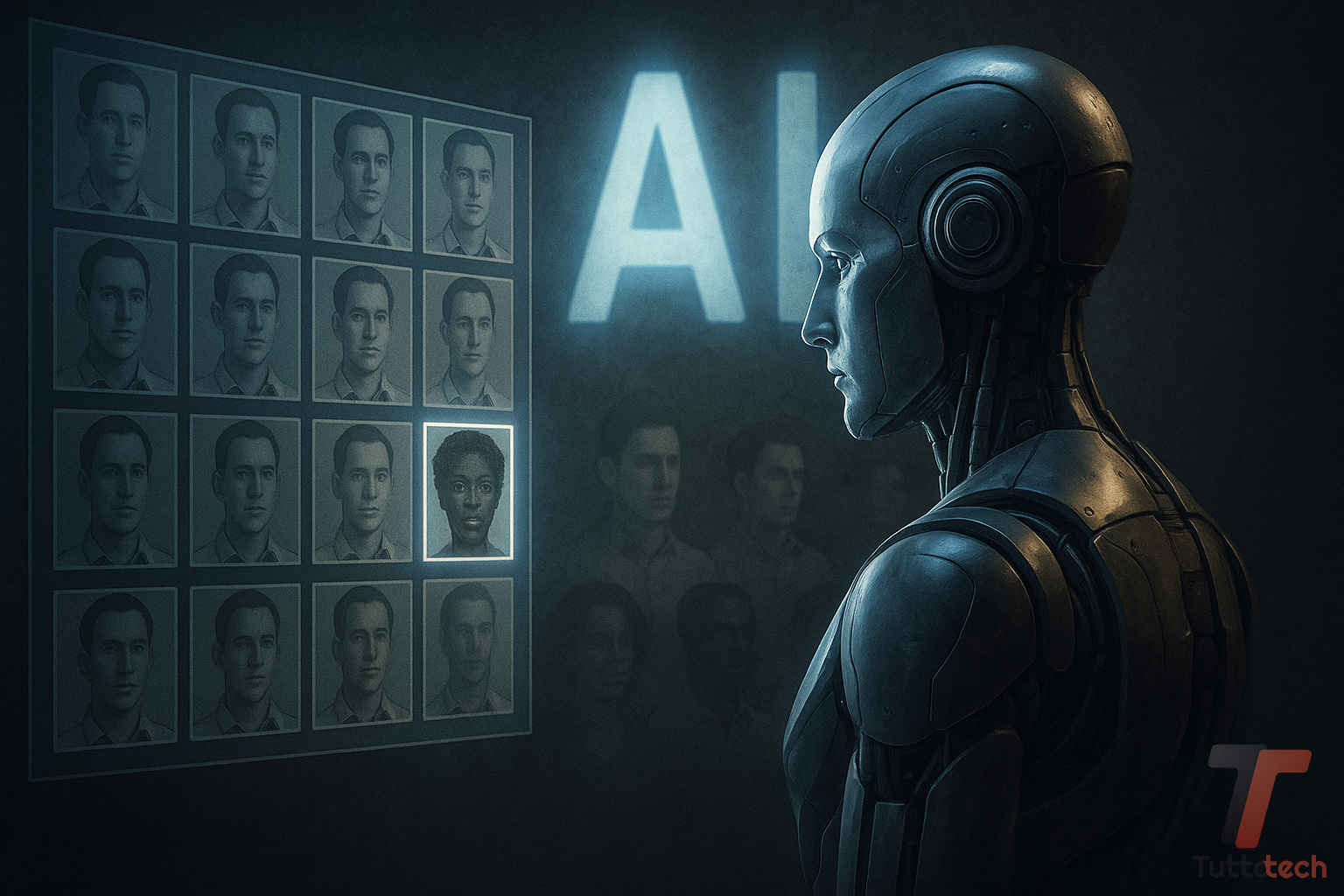

Questo fenomeno ha un nome preciso: bias. Nei sistemi di intelligenza artificiale, i bias non sono anomalie eccezionali, ma distorsioni frequenti nei dati, nei modelli o nei contesti d’uso. Possono entrare nel sistema in modo subdolo e stratificato: dalla raccolta di dati non rappresentativa, all’adozione di metriche inadeguate, fino alla mancanza di supervisione umana nei processi decisionali. È il lato oscuro dell’automazione: l’apparente neutralità dei numeri che maschera dinamiche ingiuste e spesso invisibili.

Quando i dati “insegnano” il pregiudizio

Ogni sistema di AI è, in fondo, un apprendista: impara osservando. Se le sue “esperienze” – cioè i dati di addestramento – sono distorte, lo saranno anche le decisioni. È il caso dell’erasure bias, una esclusione sistemica che rimuove interi gruppi sociali dai dataset.

Esempio classico: un riconoscimento facciale addestrato quasi esclusivamente su volti maschili e bianchi non solo avrà prestazioni peggiori su volti femminili o con tonalità della pelle più scura, ma rischia di rafforzare pratiche discriminatorie, come documentato in alcuni casi di arresti ingiustificati negli Stati Uniti. In uno studio del MIT Media Lab (2018), alcuni sistemi commerciali raggiungevano >99% di accuratezza sui volti maschili bianchi, scendendo sotto il 65% per quelli femminili neri: un divario con impatti concreti quando questi sistemi sono usati in contesti ad alto rischio (sicurezza pubblica, frontiere, sanità).

Anche il modello non scherza: consolida lo stereotipo

Non sono solo i dati a creare problemi: anche i modelli possono produrre ingiustizie se progettati senza attenzione al contesto. Esempio noto è il gender bias nei sistemi di traduzione automatica: dal turco (lingua neutra rispetto al genere) frasi come “o bir doktor” e “o bir hemşire” possono diventare “he is a doctor” e “she is a nurse”. Non per malizia, ma perché il modello ha “appreso” dal corpus che quelle associazioni sono più frequenti.

Analogamente, i sistemi di credit scoring basati su AI possono discriminare per etnia, reddito o quartiere di residenza, anche quando tali variabili non sono esplicite. Uno studio su Nature Medicine (2020) ha mostrato che un algoritmo per l’accesso ai servizi sanitari assegnava priorità più bassa ai pazienti neri perché usava come proxy la spesa sanitaria pregressa, indicatore che riflette minore accesso alle cure in sistemi già diseguali.

L’illusione più pericolosa: l’oggettività

Uno dei rischi più gravi è l’idea che un algoritmo sia neutro per definizione: non avrebbe pregiudizi, emozioni o convinzioni. Ma – come ricordano Messeri e Crockett su Nature – l’AI riflette i punti di vista presenti nei dati. Se i dati nascono in una società diseguale, l’AI può diventare un amplificatore potente di quelle disuguaglianze. Non basta invocare “più dati”. Serve piuttosto un cambio di paradigma:

- Value-Sensitive Design: integrare valori etici fin dalla progettazione (obiettivi, metriche, architetture).

- Valutazioni di fairness: testare i modelli non solo per accuratezza ed efficienza, ma per equità tra gruppi.

- Auditing algoritmico: usare metriche di bias, strumenti di audit e tecniche di de-biasing prima della messa in produzione.

- Supervisione umana e tracciabilità: prevedere il human-in-the-loop e log per la spiegabilità.

- Quadro normativo e competenze: volontà politica, formazione interdisciplinare e responsabilità chiare.

Non è solo una questione tecnica ma anche politica

La questione dei bias nell’AI non è solo tecnica: è anche politica. Chi decide cosa sia “giusto” in un sistema automatico? Chi stabilisce quali dati siano rilevanti, quali esclusioni accettabili, quali valori prioritari? L’AI oggi incide su vite reali: decide chi viene assunto, chi riceve un prestito, chi è sorvegliato e chi resta invisibile. Riconoscere il rischio di ingiustizia automatica non significa demonizzare la tecnologia, ma affrontarne con lucidità le implicazioni sociali.

È tempo di una nuova alfabetizzazione algoritmica, capace di coniugare sapere tecnico e sensibilità critica. Solo così potremo costruire un futuro in cui l’AI sia davvero al servizio di tutti.

L’intelligenza artificiale è ormai ovunque: nei motori di ricerca, nei social, nei software che usiamo per lavorare, curarci, decidere. Ma siamo davvero pronti a convivere con algoritmi che imparano, decidono, ci osservano?

Questa rubrica nasce per esplorare, con uno sguardo critico e accessibile, le sfide etiche e sociali dell’AI: dalle discriminazioni nei dati al lavoro che cambia, dalla creatività generativa alla privacy, fino al ruolo dell’umano in un mondo sempre più automatizzato.

Ogni settimana, un breve approfondimento per capire meglio cosa c’è dietro la tecnologia che ci cambia. E per iniziare a domandarci, tutti: dove vogliamo andare?

Puoi seguire la rubrica mettendo fra i preferiti la pagina che raccoglierà le varie puntate: Etica AI, oppure se utilizzi un aggregatore di notizie aggiungendo il Feed RSS di TuttoTech o più nello specifico il Feed RSS della rubrica Etica e AI.

Giovanni Di Trapani, ricercatore del CNR, economista, statitstico ed autore. Si occupa di innovazione, governance pubblica e futuro digitale. Gestisce il sito AIgnosi.it.

I nostri contenuti da non perdere:

- 🔝 Importante: NVIDIA GeForce RTX 5060 Ti 16 GB vs RTX 5060 8 GB: gaming, consumi e prezzi

- 💰 Risparmia sulla tecnologia: segui Prezzi.Tech su Telegram, il miglior canale di offerte

- 🏡 Seguici anche sul canale Telegram Offerte.Casa per sconti su prodotti di largo consumo