È ormai da diverso tempo che Apple ha presentato il suo sistema di protezione e sicurezza dei messaggi su iMessage il quale va a mascherare immagini contenenti del nudo inviate ai bambini. Questa funzionalità è stata inizialmente lanciata, come molto spesso capita, negli USA durante lo scorso anno mentre ora il supporto viene esteso ad altre nazioni, nella fattispecie si tratta del Regno Unito, Canada, Nuova Zelanda e Australia. Non è ancora stata fornita una data specifica per questo rilascio ma non dovrebbe volerci molto tempo per vederla attiva sui dispositivi Apple delle nazioni menzionate.

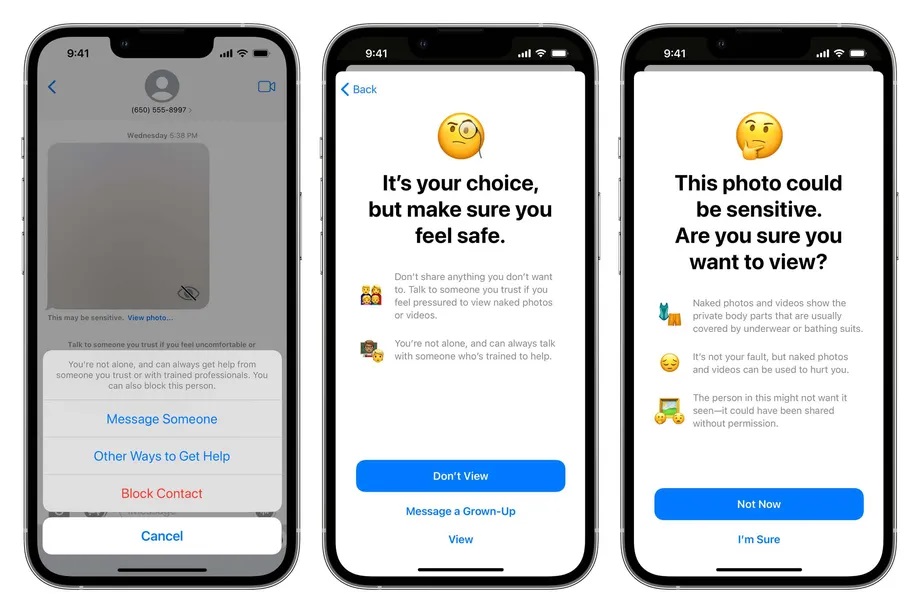

La scansione di queste foto viene eseguita sul device e non va ad impattare la connessione end-to-end che assicura la sicurezza da sempre garantita da Apple con iMessage. La funzionalità deve comunque essere attivata da uno dei genitori che fa parte di un gruppo di condivisione di file famigliari Apple. Come accennato, la funzionati scansiona immagini in arrivo o inviate dal device in modo da individuare contenuti sessuali o comunque lesivi della sensibilità dei bambini. Quando questa evenienza viene individuata, il messaggio viene sfocato e viene mostrato un messaggio che porta a cercare aiuto da una persona adulta o a lasciare la conversazione. Ovviamente rimane l’opzione per vedere la foto ma non è in alcun modo evidenziata, tutt’altro.

I bambini infatti saranno infatti incoraggiati da iMessage a contattare un adulto che conoscono ma potranno anche non farlo, in caso siano adolescenti consapevoli, che potrebbero voler preservare la propria privacy nei confronti dei genitori stessi. Inoltre il colosso di Cupertino ha anche rilasciato la funzionalità che porta gli utenti verso risorse che possono fornire aiuto nel caso in cui vengano effettuate ricerche in Spotlight, Siri e Safari che riguardino abusi sessuali subiti da minori. Questa funzionalità avrebbe dovuto fare il paio con la discussa CSAM che prevedeva la scansione di tutte le foto memorizzate su un device Apple per trovare quelle che ritraessero abusi sessuali sui bambini.

Quest’ultima funzionalità è stata accolta dall’opinione pubblica in quanto giudicata troppo invadente della privacy degli utenti e potenzialmente pericolosa in quanto avrebbe potuto creare una backdoor utilizzabile da malintenzionati per spiare gli utenti. Apple ha poi ritrattato, affermando che avrebbe ritardato il rilascio di tutte e tre le funzionalità. Ora due su tre hanno iniziato il rollout ma su CSAM non ci sono più state novità o comunicati.

I nostri contenuti da non perdere:

- 🔝 Importante: Abbiamo provato una stampante laser a colori economica per un anno e non torneremmo più indietro (video)

- 💰 Risparmia sulla tecnologia: segui Prezzi.Tech su Telegram, il miglior canale di offerte

- 🏡 Seguici anche sul canale Telegram Offerte.Casa per sconti su prodotti di largo consumo